本記事では、新規視点合成の分野における最新の画期的な研究「FSGS: Real-Time Few-shot View Synthesis using Gaussian Splatting」をご紹介します。この研究は、限られた数の画像から、まるでその場にいるかのようなリアルな3Dシーンをリアルタイムで生成する技術です。

arXiv:2312.00451v2 (2024年6月16日公開)

この論文は、The University of Texas at Austinの研究者たちによって発表されたもので、特に少ない入力画像でも高品質かつ高速なレンダリングを可能にする「Gaussian Splatting」という技術を基盤としています。VR/ARや自動運転など、多様なアプリケーションでの活用が期待されます。

新規視点合成の課題とFSGSの登場

私たちが普段目にする2D画像を基に、まだ見ていない新しい角度からの3Dシーン画像を生成する技術を「新規視点合成(Novel View Synthesis: NVS)」と呼びます。このNVSは、まるで現実世界をデジタルに再現するかのような、非常に魅力的な技術分野です。

これまで、NeRF(Neural Radiance Fields)という技術がこの分野で注目を集めてきましたが、NeRFにはいくつかの課題がありました。例えば、高品質な画像を生成するためには、非常に多くの(数百枚以上の)入力画像が必要とされ、その学習やレンダリングには膨大な計算時間とコストがかかることが一般的でした。

しかし、今回紹介する「FSGS」は、この課題を大きく乗り越えます。わずか数枚の画像からでも、NeRFベースの既存手法よりもはるかに高速かつ高品質な新規視点合成を可能にする、画期的なフレームワークなのです。

FSGSの画期的な手法:少数枚画像からの3D再構成を加速

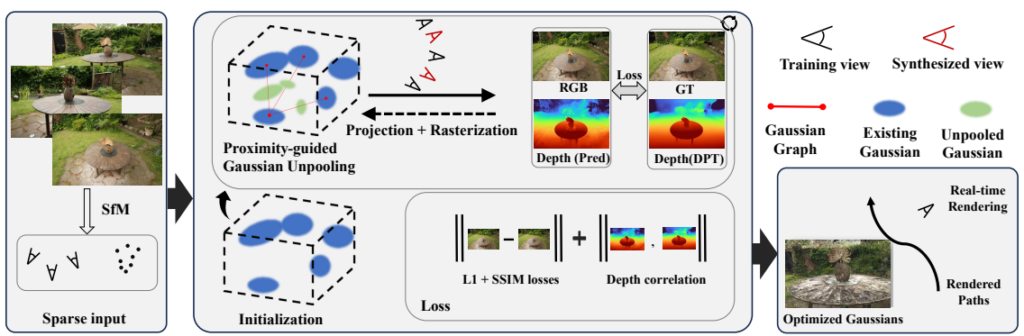

FSGS(Few-Shot Gaussian Splatting)は、少数の入力画像からリアルタイムかつフォトリアルな新規視点合成を実現するために、いくつかの革新的なアプローチを採用しています。

まず、FSGSは「3D Gaussian Splatting(3DGS)」という技術をベースにしています。3DGSは、シーンを小さな3Dのガウス分布(Gaussian)の集まりとして表現し、これをレンダリングすることで高速な画像生成を可能にします。

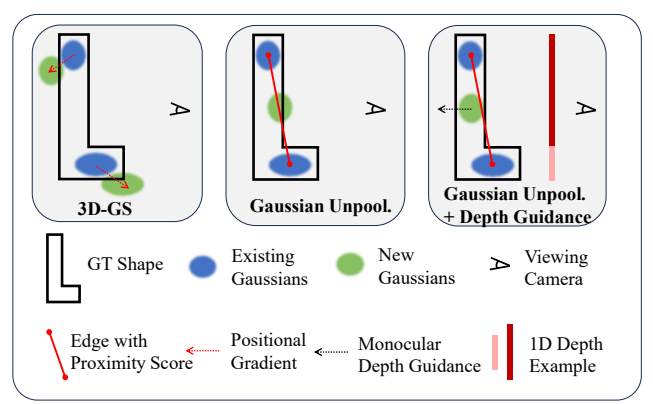

しかし、3D-GSも初期の点群が非常に少ない場合、シーン全体を正確に表現しきれないという問題がありました。FSGSは、この「極めて疎な初期点群」の課題を解決するために、独自の技術を導入しています。

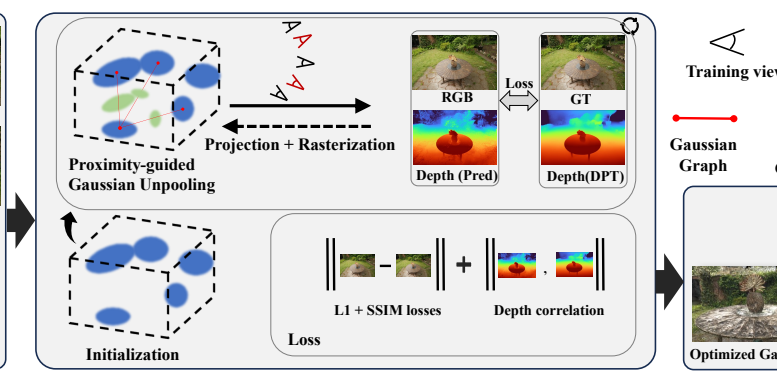

Proximity-guided Gaussian Unpooling(近接誘導型Gaussianアンプーリング)

FSGSの核となる技術の一つが、「Proximity-guided Gaussian Unpooling」です。これは、既存のGaussianが少ない場合に、その密度を効果的に高めるための戦略です。

具体的には、既存のGaussianとその近傍のGaussianとの「近接度スコア」を計算します。そして、このスコアに基づいて、既存のGaussianとGaussianの間に新しいGaussianを戦略的に配置していくことで、シーンのカバレッジを向上させます。

この手法により、初期の点群がまばらでも、シーンのより詳細な部分まで適応的に表現できるようになります。まるで空白を埋めるように、Gaussianを増やしていくイメージです。

仮想視点と幾何学的正則化による過学習の抑制と精度向上

少ない画像で学習を行うと、モデルが学習データに過剰に適合し(過学習)、未知の視点からの画像生成が不自然になることがあります。FSGSは、この問題に対処するため、以下の二つの手法を取り入れています。

一つ目は「仮想視点(Pseudo Views)」の生成です。学習データには存在しない仮想的なカメラ視点をオンラインで生成し、これらを学習プロセスに組み込むことで、モデルがより多様な視点からの情報を学習できるよう促します。これにより、実際の視差効果を再現し、汎化性能を高めます。

二つ目は「幾何学的正則化(Geometric Regularization)」です。これは、単眼深度推定器(monocular depth estimator)によって推定された深度情報と、レンダリングによって得られた深度情報との間に「ピアソン相関(Pearson correlation)」という柔らかい制約を設けるものです。

この制約により、3D Gaussianが現実的な幾何学的構造を持つように誘導されます。特に、Unpoolingで追加された新しいGaussianが、より正確で詳細なシーン再構成を促進する位置に配置されるように学習が進みます。これらの仕組みにより、過学習を防ぎつつ、テクスチャのディテールや構造の整合性を高めることが可能になります。

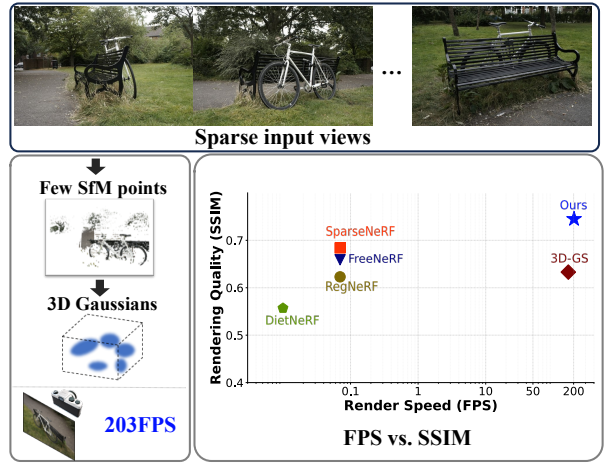

驚異的な性能:2000倍高速化と高品質の両立

FSGSは、様々なデータセット(NeRF-Synthetic、LLFF、Shiny、Mip-NeRF360など)でその性能が評価されました。その結果は目覚ましいものでした。

既存のNeRFベースの最先端手法と比較して、FSGSは卓越したレンダリング品質を実現しながら、なんと2000倍以上も速い推論速度を達成しています。特にSparseNeRFと比較すると、視覚品質(SSIM)を向上させつつ、2180倍も高速に動作します。これにより、実用的なアプリケーションへの適用可能性が飛躍的に向上しました。

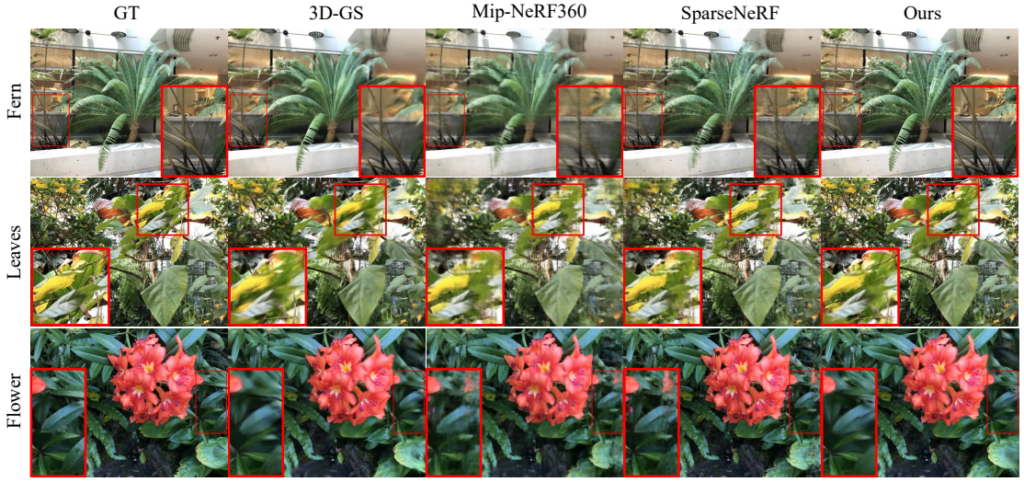

上の比較画像を見ると、NeRFベースの先行研究が複雑なジオメトリを持つ領域でぼやけた結果や不自然なアーティファクトを生じているのに対し、FSGSはより鮮明で詳細なテクスチャや構造を再構築していることがわかります。

また、興味深いことに、FSGSは標準の3D-GSよりも少ないGaussian数で、より良い性能を発揮します。これは、FSGSのProximity-guided Gaussian Unpoolingが、Gaussianを最も代表的な位置に効率的に配置・最適化していることを示しています。

アブレーションスタディ(各構成要素の有効性を検証する実験)でも、Proximity-guided Gaussian Unpoolingや相対深度正則化、仮想視点生成といったFSGSの各要素が、レンダリング品質の向上に大きく貢献していることが明確に示されました。

FSGSの応用可能性と今後の展望

FSGSの登場は、リアルタイムかつ高品質な新規視点合成の実現に向けた大きな一歩です。わずか数枚の画像から、これほど高速でフォトリアルなシーンを生成できることは、VR/ARコンテンツ制作、自動運転のシミュレーション、あるいは一般的な3Dコンテンツ作成など、多岐にわたる分野に新たな可能性をもたらすでしょう。

例えば、スマートフォンで数枚写真を撮るだけで、その場所の3Dモデルを生成し、AR空間でインタラクティブに操作するといった体験が、より身近になるかもしれません。

もちろん、まだ課題も残されています。論文では、FSGSが学習時に観測されていない「隠された(occluded)視点」への汎化は難しいと述べられています。しかし、この研究が今後のFew-shot新規視点合成の研究に新たな方向性を示すことは間違いありません。

まとめ

本記事では、リアルタイムFew-shot新規視点合成の課題に挑戦し、画期的な解決策を提示した論文「FSGS: Real-Time Few-shot View Synthesis using Gaussian Splatting」を紹介しました。

FSGSは、Proximity-guided Gaussian Unpoolingという独創的な手法と、仮想視点および幾何学的正則化を組み合わせることで、既存手法をはるかに凌駕するレンダリング品質と驚異的な処理速度を実現しました。

この技術が、私たちの3Dコンテンツとの関わり方をどのように変えていくのか、今後の展開に大いに期待が持てますね。