本記事では、2012年に発表された画期的な論文

「ImageNet Classification with Deep Convolutional Neural Networks」

を紹介します。この論文は、機械学習のトップカンファレンスであるNIPS 2012(現在のNeurIPS)で発表され、画像認識分野にディープラーニング旋風を巻き起こしました。

はじめに:画像認識のブレイクスルー

「ImageNet」という言葉を耳にしたことがありますか?

これは、何百万もの画像と、それぞれの画像に何が写っているかを示すラベルがセットになった、巨大な画像データセットのことです。

毎年「ImageNet Large-Scale Visual Recognition Challenge (ILSVRC)」という画像認識の腕を競うコンテストが開催されており、このコンテストで当時の性能を桁違いに上回る成果を出したのが、今回ご紹介する「AlexNet」と呼ばれるモデルです。

当時は、画像認識の性能を向上させるために、より多くのデータを用意したり、より洗練されたモデルを使ったり、過学習(訓練データにだけ異常に適合してしまい、未知のデータには対応できない状態)を防ぐ技術を導入したりすることが重要だと考えられていました。

これまでのデータセットは数十万枚規模が多かった中、ImageNetのような数百万枚・数千カテゴリに及ぶ大規模データセットが登場したことで、より「学習能力の高い」モデルが求められるようになりました。

そこで登場したのが、今回紹介する論文で使われた「畳み込みニューラルネットワーク(CNN)」です。CNNは、人間の視覚システムにヒントを得て開発されたモデルで、画像の「局所的な特徴」を効率的に学習できるという大きな強みがあります。

しかし、大規模な高解像度画像に適用するには、膨大な計算コストが課題でした。この論文の著者たちは、GPU(画像処理に特化した計算機)を最大限に活用し、最適化された実装を用いることで、この課題を克服しました。

彼らがILSVRC-2010で達成したトップ5エラー率17.0%(当時の最高性能は28.2%)は、それまでの常識を覆すものであり、ディープラーニングが画像認識の分野で強力な武器となることを世界に示しました。

AlexNetの革新的なアーキテクチャ

AlexNetは、5つの畳み込み層と3つの全結合層からなる、合計8層の深いニューラルネットワークです。この「深さ」こそが、モデルの強力な学習能力の源泉でした。

さらに、学習を高速化し、性能を向上させるためのいくつかの革新的な工夫が盛り込まれています。

ReLU活性化関数

従来のニューラルネットワークでは、tanh(ハイパボリックタンジェント)やsigmoidといった「飽和型」の活性化関数がよく使われていました。しかし、これらの関数は入力が大きすぎたり小さすぎたりすると勾配が非常に小さくなり、学習が停滞しやすいという問題がありました。

AlexNetでは、「ReLU(Rectified Linear Unit)」という非飽和型の活性化関数(f(x) = max(0, x))を導入しました。これは「入力が0以下なら出力は0、0より大きければそのまま出力」というシンプルな関数です。

このReLUを用いることで、従来の飽和型関数に比べて学習が数倍も速くなることが示されました。

複数GPUによる学習

当時のGPUはメモリ容量が限られており、AlexNetのような巨大なモデルを単一のGPUで学習させることは困難でした。

そこで著者たちは、2つのGPUを並列に使用する工夫を凝らしました。ネットワークの一部をそれぞれのGPUに割り当て、特定の層でのみGPU間で情報をやり取りさせることで、大規模なモデルでも効率的に学習を進めることを可能にしました。

この工夫により、エラー率をさらに改善することができました。

局所応答正規化(Local Response Normalization)

ReLU活性化関数は、入力の正規化を必須としませんが、この論文では「局所応答正規化」という技術を導入しています。

これは、あるニューロンの活動を、同じ位置にある周囲のカーネルマップ(特徴マップ)の活動と比較して正規化するものです。この手法は、生物の神経細胞に見られる「側方抑制」というメカニニズムにヒントを得たもので、隣接するニューロンとの競争を促し、汎化性能(未知のデータに対する適用能力)を向上させる効果がありました。

オーバーラッププーリング(Overlapping Pooling)

CNNのプーリング層は、特徴マップの情報を集約する役割を持ちます。従来のプーリングでは、集約する領域が隣接するプーリング単位と重ならないように設定されていました。

しかしAlexNetでは、プーリング領域を少しだけ重ねる「オーバーラッププーリング」という手法を採用しました。これにより、わずかではありますが、トップ1・トップ5のエラー率を改善し、モデルが過学習しにくくなる効果も確認されました。

過学習を防ぐための工夫

AlexNetは6000万個もの膨大なパラメータを持つため、過学習は避けられない問題でした。この問題に対処するために、以下の二つの強力な手法が導入されています。

データ拡張(Data Augmentation)

画像認識モデルの過学習を防ぐ最も一般的な方法は、訓練データを人工的に増やす「データ拡張」です。AlexNetでは、主に以下の二つの方法でデータ拡張を行いました。

- 画像の切り出しと反転: 元の256×256ピクセルの画像から、ランダムに224×224ピクセルのパッチを切り出したり、それを水平方向に反転させたりして、訓練画像として利用しました。これにより、実質的に訓練データのサイズを2048倍に増やしています。テスト時には、画像の4隅と中央、そしてそれらを反転させた計10個のパッチを切り出し、それぞれの予測を平均することで、より安定した結果を得ました。

- RGBチャネル強度の変更: 画像のRGB(赤、緑、青)各チャネルの強度をランダムに変化させることで、照明の変化に対するモデルの頑健性を高めました。これは、ImageNetデータセット全体のRGBピクセル値に対して主成分分析(PCA)を行い、その主成分にランダムな値を加えて画像に適用するものです。これにより、同じ物体でも照明条件が異なれば別物と認識してしまう、という問題を軽減できます。

ドロップアウト(Dropout)

ドロップアウトは、過学習を防ぐために非常に効果的な正則化手法です。訓練中に、各隠れ層のニューロンの出力を、確率0.5でランダムに「0」に設定します。

これにより、ニューロンは他の特定のニューロンに依存することなく、より汎用的な特徴を学習することを強いられます。

訓練時には毎回異なるネットワークの構造がサンプリングされる形になり、あたかも多数の異なるモデルを組み合わせて学習しているような効果が得られます。

テスト時には、全てのニューロンを使用しますが、その出力を0.5倍することで、多数のドロップアウトネットワークの予測を近似的に平均する効果を得ます。AlexNetでは、最初の2つの全結合層でドロップアウトが適用され、過学習を大幅に軽減することに成功しました。

学習の道のり

AlexNetは、確率的勾配降下法(SGD)を用いて学習されました。バッチサイズは128、モーメンタムは0.9、重み減衰(weight decay)は0.0005という設定です。

重み減衰は、単なる正則化だけでなく、訓練エラーを減らすためにも重要だとされています。

学習率は、検証エラー率の改善が停滞したときに10分の1に減らすという手動調整が行われました。初期学習率は0.01で、学習終了までに3回減らされました。

この巨大なネットワークの訓練には、2つのNVIDIA GTX 580 3GB GPUを使用し、約120万枚の訓練画像を約90サイクル学習させるために、5〜6日かかりました。これは、当時の最先端の計算資源をフル活用した大規模な挑戦でした。

驚異的な成果

AlexNetがILSVRC-2012コンペティションで達成した成果は、当時の画像認識の常識を覆すものでした。

ILSVRC-2010での成果

| モデル名 | Top-1 エラー率 | Top-5 エラー率 |

|---|---|---|

| Sparse coding | 47.1% | 28.2% |

| SIFT + FVs | 45.7% | 25.7% |

| AlexNet (CNN) | 37.5% | 17.0% |

ILSVRC-2012での成果

| モデル名 | Top-1 (検証) | Top-5 (検証) | Top-5 (テスト) |

|---|---|---|---|

| SIFT + FVs | — | — | 26.2% |

| 1 CNN (AlexNet) | 40.7% | 18.2% | — |

| 5 CNNs の平均 | 38.1% | 16.4% | 16.4% |

| 7 CNNs の平均* | 36.7% | 15.4% | 15.3% |

*アスタリスク付きのモデルは、より大規模なImageNet Fall 2011データセットで事前学習されています。

AlexNetは、単一モデルでもトップ5エラー率18.2%を達成し、当時の2位のモデル(26.2%)を大きく引き離しました。

さらに、複数のAlexNetモデルの予測を平均したり、より大規模なデータセットで事前学習を行ったりすることで、最終的には15.3%という圧倒的なトップ5エラー率でコンペティションに優勝しました。この結果は、ディープラーニングが従来の画像認識手法を凌駕する可能性を明確に示しました。

AlexNetが「見ている」世界

AlexNetは、単に高い認識精度を出しただけでなく、その内部でどのような特徴を学習しているのかを視覚的に理解できる点も興味深いところです。

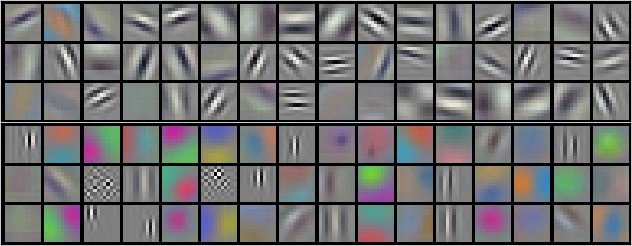

学習された畳み込みカーネル

最初の畳み込み層が学習したフィルター(カーネル)を見てみましょう。

この画像は、AlexNetの最初の畳み込み層が学習した96個のフィルターを示しています。

これらは、画像からエッジや特定のパターン、色の組み合わせなどを検出する役割を果たします。上半分と下半分はそれぞれ異なるGPUで学習されたフィルターで、GPUによって学習される特徴に専門性が見られることが分かります。

例えば、一方のGPUは色にあまり依存しない一般的な形状の特徴を、もう一方のGPUは色に特化した特徴を学習しているようです。

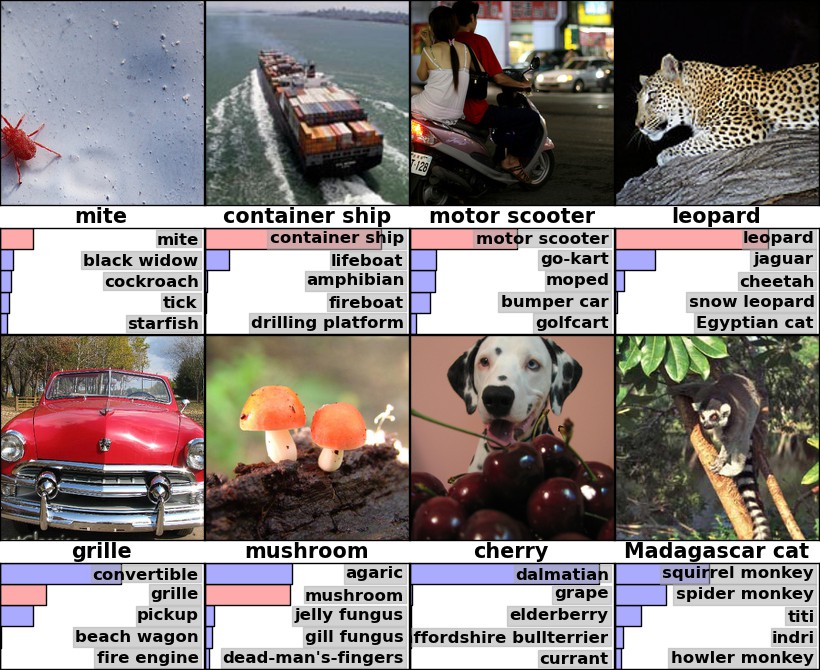

画像分類の具体例

AlexNetがどのように画像を分類しているか、いくつかの例を見てみましょう。以下の画像は、テスト画像と、AlexNetが最も確信した上位5つのラベルの予測結果を示しています。

例えば、左上のダニ(mite)の画像では、中心からずれていても「ダニ」と正しく認識し、次に確信度の高いラベルとして「黒い未亡人グモ」「ゴキブリ」「ダニ(tick)」「ヒトデ」といった関連する小さな生物を挙げています。これは、モデルが単に中心の物体だけでなく、画像全体の文脈を理解しようとしていることを示唆しています。

また、ヒョウの画像では、他のネコ科動物が予測の上位に来ており、非常に適切な予測であることが分かります。

まとめと今後の展望

AlexNetの登場は、ディープラーニングが画像認識の分野でいかに強力であるかを世界に知らしめ、その後のAI研究の大きな流れを決定づけるきっかけとなりました。この論文は、深いネットワーク構造、ReLU活性化関数、複数GPUによる効率的な学習、データ拡張、そしてドロップアウトといった、現在のディープラーニングモデルでも当たり前のように使われている多くの技術の有効性を実証しました。

AlexNetは、現代のAI技術の基礎を築いた偉大な論文の一つであり、その革新的なアイデアは今なお多くの研究者やエンジニアに影響を与え続けています。この論文が切り開いた道が、今日の画像認識技術の発展へと繋がっているのです。