論文情報: Zero-Shot Text-to-Image Generation

はじめに

近年、AI技術の進化は目覚ましく、特にテキストから画像を生成する技術は大きな注目を集めています。まるで魔法のように、言葉を打ち込むだけで、AIがその言葉に合わせた魅力的な画像を生成してくれるのです。

今回ご紹介する論文「Zero-Shot Text-to-Image Generation」は、OpenAIによって発表された、その画期的な技術「DALL-E」に関するものです。

この研究は、大規模なTransformerモデルと膨大なデータセットを用いることで、これまでの画像生成モデルの常識を覆すような成果を達成しました。

初心者の方にも分かりやすく、DALL-Eがどのようにしてテキストから画像を生成するのか、その驚きの能力の秘密を深掘りしていきましょう。

DALL-Eとは?

DALL-E(ダリ)は、テキストの指示に基づいて画像を生成するAIモデルです。

その名前は、有名な画家サルバドール・ダリと、ピクサー映画「ウォーリー」に登場するロボット「WALL-E」にちなんで名付けられました。

この論文のタイトルが示す通り、「Zero-Shot」での画像生成能力が大きな特徴です。Zero-Shotとは、事前に学習していない、全く新しいテキストの指示に対しても、適切な画像を生成できることを意味します。

DALL-Eは、テキストと画像を「トークン」と呼ばれる単位に変換し、これらを一連のデータストリームとして扱うことで、あたかも文章を生成するように画像を生成します。

画像を生成する2段階の仕組み

DALL-Eの画像生成は、主に2つの段階を経て行われます。

Stage 1: dVAEによる画像圧縮

まず、入力された画像(または生成される画像の元となる情報)は、Discrete Variational Autoencoder (dVAE) という特殊なモデルによって圧縮されます。これは256×256ピクセルのRGB画像を、32×32の「画像トークン」という小さな表現に変換するプロセスです。

この圧縮により、Transformerモデルが扱うデータ量が大幅に削減され、高解像度画像を効率的に処理できるようになります。元の画像の詳細の一部は失われるものの、オブジェクトの視覚的に認識可能な主要な特徴は保たれます。

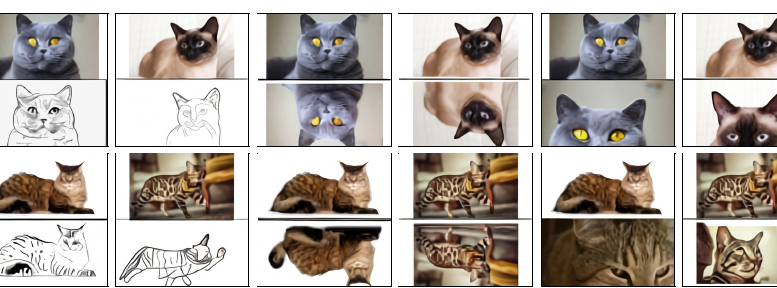

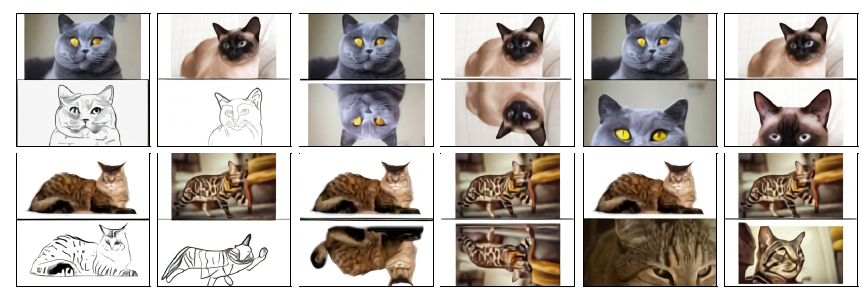

上の画像のように、オリジナルの画像(上段)は、dVAEによって再構成された画像(下段)と比較しても、その大まかな構造や主要な要素が維持されていることが分かります。

細部のテクスチャなどはやや失われますが、この圧縮が大規模なモデルの学習を可能にする鍵となります。

Stage 2: Transformerによるテキストと画像トークンの学習

次に、この画像トークンと、ユーザーが入力した「テキストプロンプト」(これもBPEエンコードされたテキストトークンに変換されます)が連結され、一つの長いシーケンスとしてTransformerモデルに与えられます。

DALL-Eは、このテキストと画像トークンのシーケンス全体を自己回帰的に学習します。つまり、与えられたテキストに続いて、適切な画像トークンを一つずつ予測していくことで、最終的な画像を生成するのです。このTransformerは120億もの膨大なパラメータを持ち、大量のデータから多様なパターンを学習しています。

DALL-Eが示す驚くべき能力

DALL-Eの最大の魅力は、その驚くべき生成能力と柔軟性です。単に既存の画像を模倣するだけでなく、これまで見たことのないようなユニークなコンセプトを組み合わせた画像を生成できます。

例えば、「アコーディオンでできたtapir(バク)」のような、現実には存在しないような組み合わせも、テキストの指示通りに生成することができます。また、「”backprop”と書かれたネオンサイン」のように、テキストを画像内にレンダリングする能力も持っています。

上の画像は、DALL-Eが生成した多様な例の一部です。テキストで指示された通りの、斬新で創造的な画像を生成できることが分かります。

これは、モデルが単語の意味だけでなく、それらの概念間の関係や、世界がどのように機能するかについての深い理解を獲得していることを示唆しています。

さらにDALL-Eは、「Zero-Shot Image-to-Image Translation」(テキスト指示による画像から画像への変換)という、予期せぬ能力も発揮します。

これは、元の画像の一部(またはそのトークン)とテキストプロンプトを与えることで、その画像に特定の変換を施すことができるというものです。

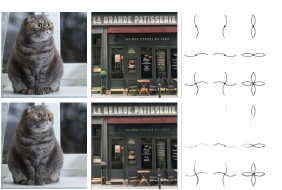

この画像は、上段の猫の写真を元に、「全く同じ猫が下段にスケッチとして描かれている」という指示で、下段にスケッチ風の画像を生成した例です。このように、テキスト指示だけで画像のスタイルを変更したり、属性を調整したりする能力は、画像編集の新たな可能性を広げます。

人間による評価でも、DALL-Eの生成する画像は、既存の最高峰のモデルと比較して、「よりリアル」であると90%の時間で、「キャプションとより一致する」と93%の時間で評価されました。

大規模学習を支える技術

DALL-Eのような大規模モデルの学習は、非常に困難な課題です。この研究では、その課題を克服するために様々な技術的な工夫が凝らされています。

DALL-Eは、インターネットから収集された2億5千万もの画像-テキストペアという、途方もない規模のデータセットで学習されました。

また、GPUメモリを節約し、計算スループットを向上させるために「混合精度学習」や「分散最適化」の手法が採用されています。

特に、120億パラメータという巨大なモデルを安定して学習させるために、「per-resblock gradient scaling」や「PowerSGD」による勾配圧縮といった独自の手法が開発されました。これらの技術がなければ、これほどの規模のモデルを実用的に学習させることは不可能だったでしょう。

まとめ

OpenAIの「Zero-Shot Text-to-Image Generation」論文は、DALL-Eという画期的なモデルを通じて、テキストから画像を生成する技術の新たな地平を切り開きました。

大規模なTransformerモデルと膨大なデータ、そして巧妙な学習技術の組み合わせにより、DALL-Eは単に高品質な画像を生成するだけでなく、創造的なコンセプトの組み合わせや、テキスト指示による画像変換といった驚くべき汎化能力を示しました。